Segundo o Público, a partir de 2 de fevereiro, os governos de toda a União Europeia (UE) teriam a possibilidade de recorrer a tecnologias baseadas em inteligência artificial (IA, em inglês) para seguir cidadãos em espaços públicos e efetuar vigilância em tempo real sobre refugiados nas fronteiras, assim como utilizar meios de reconhecimento facial sobre pessoas suspeitas, com base nas suas opções políticas ou crenças religiosas.

A aprovação do Regulamento Europeu da Inteligência Artificial deu luz verde dos governos dos 27 Estados membros à primeira estrutura legal que tem como objetivo regular o uso desta ferramenta. À proposta aprovada no Parlamento Europeu, a Comissão Europeia acrescentou exceções à lei, sob a pressão de França com o apoio de países como a Hungria e Portugal. Citada pelo Público, a Investigate Europe revelou que estes Estados trabalharam para limitar as restrições ao uso da IA, atribuindo às autoridades policiais e fronteiriças maior liberdade para vigiar os cidadãos.

Terá sido ainda o governo anterior, liderado por António Costa, a criticar o alargamento das proibições às forças de segurança na utilização de IA. “A exclusão da segurança e da defesa (…) deve ser mantida a todo o custo”, reclamaram os representantes franceses em nome da “segurança nacional”. De acordo com o Público, estas isenções abrangem também as empresas privadas – e até países terceiros – que fornecem a tecnologia de inteligência artificial às polícias. Um dos juristas do Partido Popular Europeu, contactado diário português, assumiu que o artigo em causa vai “contra todas as constituições” e “contra os direitos fundamentais”. Sob anonimato, garantiu que “a França poderia, por exemplo, pedir ao governo chinês que utilizasse os seus satélites para tirar fotografias e depois vender os dados ao governo francês.”

Na prática, a utilização de sistemas de reconhecimento emocional, que interpretam o humor ou os sentimentos humanos, está proibida nos locais de trabalho, escolas e universidades. As empresas também estão impedidas de utilizar ferramentas que captem as suas intenções de compra e os patrões não podem analisar o comportamento dos seus trabalhadores para verificar se estão satisfeitos ou se é provável que abandonem a empresa. Contudo, estas proibições não abrangem as autoridades, que podem usar estes sistemas, assim como recolher imagens de qualquer indivíduo ou dados sobre a raça, as opiniões políticas, a religião, a orientação sexual ou mesmo a filiação sindical.

No debate, a França sublinhou que é “muito importante preservar a possibilidade de procurar uma pessoa que exprima uma crença religiosa ou uma opinião política, como o uso de um distintivo ou acessório, quando essa pessoa está envolvida em extremismo violento ou apresenta um risco terrorista”. No caso do software de reconhecimento facial, este pode ser usado pela polícia na investigação de 16 crimes específicos, incluindo uma referência geral a “crimes ambientais”. De acordo com o Público, a utilização desta tecnologia em espaços públicos “significa o fim do anonimato nesses locais”, alertou a Rede Europeia de Direitos Digitais em 2020.

Os perigos da utilização da IA

Em 2020, rebentou um escândalo na Holanda depois de ser tornado público um relatório de uma comissão de inquérito parlamentar que concluía que milhares de famílias, sobretudo imigrantes, tinham perdido apoios sociais quando falsamente acusadas de fraude. A dois meses das eleições legislativas, o governo acabou por se demitir.

De acordo com um relatório da Amnistia Internacional, o algoritmo usado pela ferramenta que determinava quem recebia ou não subsídios de cuidados infantis usava a nacionalidade como critério para se ser assinalado com a classificação de risco. Nesse sentido, o algoritmo, como mecanismo de autoaprendizagem, apontou os cidadãos não holandeses como mais suspeitos de terem cometido alguma fraude do que os nacionais da Holanda. Durante seis anos, entre 2013 e 2019, cerca de 26 mil famílias foram lesadas por esta ferramenta, perdendo acesso ao subsídio que lhes permitia manter os filhos com menos de 12 anos em creches ou estabelecimentos de ensino.

Em contexto militar, os perigos são evidentes. Em abril de 2024, uma notícia da CNN dava conta de que, segundo uma investigação da +972 Magazine e Local Call, com recurso a seis funcionários da inteligência israelita envolvidos, a revisão humana da seleção de alvos do Hamas e outras organizações por inteligência artificial era superficial. As autoridades israelitas afirmaram que a ferramenta se chama “Lavender” e tem uma taxa de erro de 10%. Um programa conhecido como “The Gospel” sugere edifícios e estruturas onde os combatentes da resistência palestiniana podem estar a operar.

Em 2024, Hadrien Pouget, que estuda ética da IA no Carnegie Endowment for International Peace, em Washington, e o seu colega Johann Laux, da Universidade de Oxford, no Reino Unido, destacaram a necessidade de entidades reguladoras independentes, bem como de transparência por parte dos fornecedores de IA, numa carta aberta ao Gabinete de IA da União Europeia.

Eugénio Oliveira, professor emérito da Universidade do Porto, onde fundou o Laboratório de Inteligência Artificial e Ciências de Computadores, afirma à Voz do Operário que há que recordar que a IA “é uma disciplina científica com quase 70 anos e com um enorme crédito de realizações de grande relevância para a humanidade”. Ainda assim, sublinha, é importante questionar a “utilização abusiva e maleficiente” desta tecnologia, sobretudo na produção de informação falsa, na aplicação da IA no âmbito militar em Sistemas de Armas Autónomas Letais (LAWS, em inglês) e na vigilância policial dos cidadãos.

Nesse sentido, alerta para os perigos do reconhecimento facial, ou mesmo pela retina, naquilo que se pode vir a tornar um “verdadeiro Big Brother omnipresente”. Na União Europeia, não se pode captar imagens de cidadãos para fins de identificação individualizada a não ser em casos específicos como o da prevenção do terrorismo, entre outras excepções. Mas é pelos detalhes “que o diabo pode entrar”, diz o professor, que recorda que tanto os Estados Unidos como o Reino Unido dispensam essas restrições.

É nas restrições que o debate se concentra num mercado tecnológico altamente competitivo em que nenhum país quer ficar para trás. Os cidadãos devem ser críticos mas evitar o ludismo, considera, recordando que, em 2018, assinou uma carta aberta do Instituto Future of Life, fundado no MIT, contra o uso das LAWS, sistemas que autonomamente identificam alvos a abater e matam sem intervenção direta humana. Mas a robotização autónoma, destaca, encontra problemas no desenvolvimento destes sistemas por empresas privadas como a Lockheed e Raytheon nos Estados Unidos ou a Thales Groups em França. “Não terão acesso a muitos dados protegidos pelos governos e, portanto, [os algoritmos] poderão resultar mal treinados e cometer erros letais”, afirma. E antecipa, para um futuro nada distante, “a hibridização de soldados com eletrónica cerebral permitindo ligação automática com indivíduos nos centros de decisão com visão aumentada e transmissão imediata de ordens”. É nesse tipo de implantes que trabalha a Neuralink de Elon Musk e que pode vir a ser usado com esses fins.

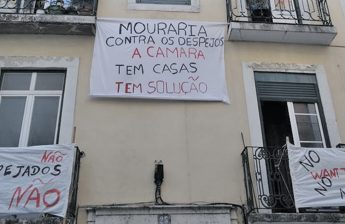

Consequências para a liberdade e democracia

Os sistemas de IA podem vir a pôr em causa a liberdade dos cidadãos dependendo de como esteja treinado o algoritmo e do controlo dos seus resultados por seres humanos. Pedro Miguel Freitas, professor na Faculdade de Direito da Universidade Católica do Porto, estuda o impacto deste desenvolvimento tecnológico do ponto de vista jurídico e considera que pode afetar a privacidade das pessoas e a liberdade de expressão. À Voz do Operário, explica que as exceções introduzidas às práticas proibitivas da utilização de IA pela União Europeia circunscrevem-se a determinados crimes. Uma das regras é a proibição de dar uma classificação de risco no sentido de antecipar se alguém pode vir a praticar um crime no futuro a partir das suas características pessoais e da sua personalidade. “Há sempre um ser humano a tomar a decisão final e essa avaliação de risco tem de estar ligada a um facto que já tenha ocorrido, não é um relatório minoritário”, explica.

Contudo, os Estados Unidos já usam sistemas para classificar os cidadãos consoante o risco de virem a cometer crimes. Há determinados estados norte-americanos, descreve, em que estes sistemas “atribuem uma nota de risco sobre a possibilidade dessa pessoa voltar a cometer um crime e esse resultado é usado para decidir a medida de coação ou mesmo liberdade condicional”. De acordo com Pedro Miguel Freitas, não se pode correr o risco de atribuir decisões exclusivamente a esses sistemas. Do que tem observado, considera que os modelos de IA “tendem a gerar mais falsos positivos” quando se trata de cidadãos negros. Os sistemas replicam o que aprenderam e “se a sociedade é discriminatória e racista” vai exacerbar o que aprendeu e vai limitar de uma forma injustificada a liberdade de determinadas pessoas por serem de determinada etnia.

Aponta ainda o aumento da falta de transparência quanto mais complexos forem os sistemas de IA. “Sabemos que dados entram no sistema e sabemos o resultado de 0 a 10 na classificação de risco, mas nem os cientistas de computação conseguem explicar como é que o sistema chegou a determinada conclusão. Do ponto de vista jurídico é altamente problemático. Como é que podemos recorrer de uma decisão cujo fundamento ou cujas razões são inexplicáveis?